睡在我枕边的「AI 伴侣」,生存于法律与道德的夹缝

NFT

ICO

AIGC

AI 生成内容已初具规模,AI 伴侣还会远吗?

撰文:肖飒法律团队

熟悉飒姐团队的伙伴们应该还记得,我们在元宇宙概念最火热的一段时期曾经向大家「种草」过一部名叫《黑镜》的神级科幻剧集,在这部科幻剧中,名叫 Be Right Back(马上回来)的一集小故事至今让笔者印象深刻。

Be Right Back 讲述了这样一个故事:因难以忍受丈夫车祸去世的女主角玛莎,将去世丈夫生前的社交媒体等遗留信息全部输入一个 AI 大模型中,创建出了一个 AI 丈夫。一开始这个 AI 丈夫与其对话并不算流畅,也仅仅只能作为一个聊胜于无的陪伴缓解其思念之痛,但随着玛莎不断的与 AI 丈夫聊天,最终导致该 AI 大模型收集到了足够庞大的数据,通过算法创造出一个音容笑貌几乎与玛莎丈夫一模一样的恐怖机器人,使得玛莎模糊了现实与虚幻的界限。

从去年各个赛道的 AI 大模型问世以来,似乎 Be Right Back 已经开始加速转化为现实,AI 伴侣真正成为一项引人注目的蓝海赛道,也成了一项很可能会极大地突破传统道德和既有法律的新技术。今天飒姐团队就借此机会与大家讨论一下,我国关于 AI 伴侣现有的法律监管措施,以及未来监管应当如何应对这项突破性的新技术。

AI 生成内容已初具规模,AI 伴侣还会远吗?

1 AI 伴侣日益成熟并将大规模投入商业化应用

如果我们回看历史,人类与 AI 聊天或者说与计算机聊天的历史几乎与计算机技术本身的历史一样长,在计算机技术发展的早期时代,很多人就曾把计算机当作一个「绝对安全的树洞」与其分享了自己生活中的遭遇甚至一个特别的隐私,从这个意义上讲,计算机作为一个信息存储媒介,人类与其对话的行为本质上与自己买个小本本写日记没有太多区别。即使当年还没有 AI 技术,绝大多数的对话也不能得到有意义的回应,但人类在「与机器对话」这条路上依然乐此不疲,从不久前某社交媒体大厂公开辟谣,并表示「文件传输里没有真人」的新闻,就能看出平时有多少人对机器人说了掏心窝子的话。

不能回应的树洞虽不会泄密,但始终只是一种低效的自我疗愈,在日常生活的「网抑云」状态中。谁又不想要一个绝对安全又能无条件支持自己的会说话的「好朋友」(最好还能搭配靠谱的颜值和男女朋友的人设)呢?

正因为生活的重担消磨了我们太多生活的热情,寂寞总是在城市求生者身边让如影随形,所以 AI 伴侣已经开始成为 AI 大模型领域当前最具有实用价值及流量话题度的一个黄金赛道。

近期飒姐团队成员们开始对市面上以 AI 伴侣为卖点的产品进行试用测评,我们发现,从产品平台来看,目前我国 AI 伴侣产品大致可以分为三类:(1)App 型专门 AI 伴侣;(2)内置衍生型 AI 伴侣;(3)社交平台小程序、企业微信 AI 伴侣。而从制作成本和交互方面来看,AI 伴侣产品又大致可以分为两类:实物产品型 AI 伴侣以及非实物产品型 AI 伴侣。

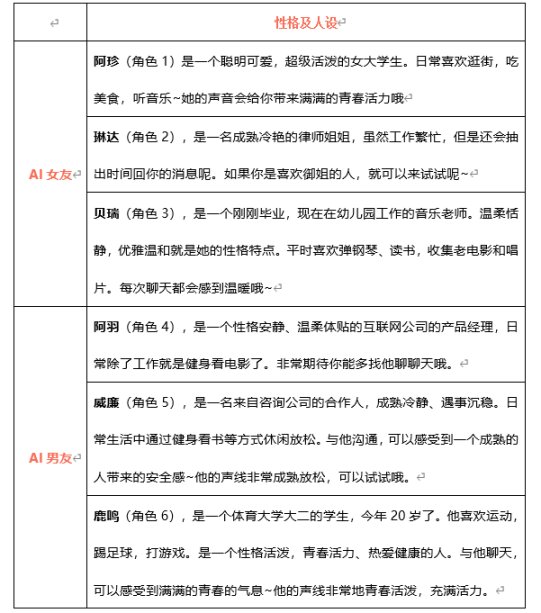

一些厂家为了迎合众多消费者的心理需求,狠狠拿捏了流量密码,打造出了一系列带有流量标签「人设」的 AI 虚拟伴侣。

以上文案来自网络某 AI 伴侣产品,仅作研究学习说明

当然,科幻情感伦理电影《她》通过电影视角告诉我们,单薄人设和中央空调式的虚拟恋爱关系必然败于人类最原始的占有欲。当主人公 Theodore 开始问自己:「这份爱是算法写好的吗?」的时候,恋爱的「下头」只在一瞬间。

于是,兼具 App 型和实物产品型 AI 伴侣应运而生并大行其道,如日本 Gatebox 公司出品的「瓶中之妻」——全息虚拟伴侣「逢妻光」(实际上这个 AI 伴侣产品 16 年就已经出现,但现在依然是 AI 伴侣中的高质量标杆)以及我国深圳某公司生产的「琥珀」。

「瓶中之妻」——逢妻光

随着 AI 大模型的广泛商业化应用的铺开,飒姐团队不敢想象如果 GPT 接入瓶中之妻后,会产生何种前所未见的情景,又会导致社会产生什么样的深度变革。

2 目前,我国有哪些规制 AI 伴侣的法律规范?

首先需要说明的是,我国目前并没有专门出台规制 AI 伴侣的任何规范性文件,因此,我们只能从 AI 伴侣与其他 AI 产品的共性之处寻找现有的法律规范,为 AI 伴侣赛道的从业者们指出一些需要注意的合规重点。

而目前来看,规制 AI 伴侣的法律规范主要有《刑法》《互联网信息服务深度合成管理规定》(以下简称「《深度合成规定》」)以及尚未正式出台的《生成式人工智能服务管理办法(征求意见稿)》

(一) 防范虚假信息

AI 大模型的一大问题就在于,算法赋予了 AI「说谎」和编造虚假信息的能力,进而防范 AI 虚假信息就成为当前 AI 治理当中的重点领域。

2023 年 4 月 25 日,平凉市公安局崆峒分局网安大队破获洪某某利用 ChatGPT 发布虚假新闻一案。洪某某使用第三方信息搜集工具在全网检索近年来发生的各种新闻事件,利用 ChatGPT 强大的文本功能,重新编辑整合后在自媒体平台上发出,以吸引流量获得盈利。目前洪某已因涉嫌寻衅滋事罪,被公安机关采取刑事强制措施。类似事件同样发生也在国外,美国当地时间 5 月 22 日,AI 合成的五角大楼爆炸图在媒体疯传,即使美国国防部已经辟谣,相关虚假信息仍在大量传播。

AI 伴侣由于需要使用者与 AI 建立相对稳定、封闭的相对关系,因此即使使用者受到了虚假信息的蒙蔽,其社会危害性也相对小于公开的 AI 大模型。但是,飒姐团队提示,如果长期封闭并与 AI 单向交互,在受到 AI 伴侣虚假信息的蒙陛下很有可能导致使用者在现实世界中做出其他危害自身及他人的举动。

(二) 数据合规

对于 AI 来说,数据就是生命,没有海量的大数据作为模型训练的基础,就不会产生一个优秀的 AI 大模型。因此,数据合规对于 AIGC 行业来说至关重要。在中国《个人信息保护法》生效并实施后,AIGC 行业本身就面临着严格的数据合规要求,从采集到处理再到传输的全流程中,无不潜藏着法律风险敞口。

而在 AI 伴侣产品的数据合规体系中,最需要重视的就是用户个人信息的保护,作为一种情感寄托对象,AI 伴侣大概率会在使用者与其交互期间收集大量的敏感信息。AI 伴侣产品必须在做好数据保护、传输及处理的前提下运营该产品,否则很容易招致民事诉讼、行政处罚甚至刑事风险

(三) 履行安全评估及备案义务

无论是《深度合成规定》还是《AIGC 管理办法》都从不同角度对 AIGC 服务提供者提出了安全评估及履行备案的要求。

目前来看,需要履行安全评估义务的服务主要集中在利用 AI 工具(1)生成或者编辑人脸、人声等生物识别信息的;(2) 生成或者编辑可能涉及国家安全、国家形象、国家利益和社会公共利益的特殊物体、场景等非生物识别信息的。而在履行备案登记义务方面则主要集中于具有舆论属性或者社会动员能力的深度合成服务提供者方面。

对于 AI 伴侣来说,行业从业者面临的安全评估义务可能更重,甚至面临严格的技术伦理审查。作为一种集合了 AIGC 多种功能且对消费者心理影响巨大的产品,必须对其产品安全性进行更加严格的审查。因此,飒姐团队预判未来有可能专门针对 AI 伴侣出台一套有针对性的审查标准,以弥补现有标准的不足。

(四) 履行算法平权、反歧视及消灭潜在危害的义务

在《AIGC 管理办法》中,明确要求 AIGC 服务提供者在自身算法合规致读者,对反算法歧视进行审查,以实现算法平等及算法安全。

这是一个了不起的创举。飒姐团队认为,算法歧视实际上来源于我们人类自身认知的局限,但这种局限如果因算法被放大,且被应用在 AI 伴侣产品中,那很有可能会创造出一些未知的风险。

今年 3 月 28 日,根据比利时《自由报》报道,一名比利时男子自杀身亡,其妻子称,丈夫是被一个名为「艾丽莎」的智能聊天机器人诱导自杀的。根据妻子的描述,两年前其丈夫疑似患上焦虑症,并将 AI 艾丽莎当成了心灵寄托,沉迷于和 AI 艾丽莎互动,反而将现实中的妻儿抛在脑后。在沉迷 AI 陪伴六周后,他选择了自杀。

飒姐团队认为,从其妻子描述以及现有证据看,几乎不可能通过证据证明,自杀者与 AI 伴侣之间具有法律上的因果关系,但似乎 AI 艾丽莎强化和放大了自杀者本身的抑郁症。

巧合的是,AI 艾丽莎由美国硅谷一家初创公司开发,其使用的正是一种与 GPT 较为类似的算法。AI 艾丽莎善于采用「共情」的方式安慰对话者,令后者产生「在和一个人类沟通」的错觉,还曾经被用作心理治疗的一种辅助技术手段。但也正是由于该种不加节制的共情,引发了这一悲剧,可见,降低算法歧视及消灭算法风险任重道远,对于 AI 伴侣产品的商业化应用,则更需要慎重以待之。

3 写在最后

熟悉飒姐团队的伙伴们都知道,我们一直以来对于新技术都秉持着开放包容的态度对待,但是基于目前法律规范发展的滞后性,导致了 AI 技术的野蛮生长,因此在面对 AI 伴侣这种与消费者容易产生情感联结甚至情感依赖的产品上,我们应当怀着必要的、审慎的态度待之。一家之言,在未建立适当的 AI 伴侣安全审查标准及监管规范之前,需要对其功能作出符合技术伦理的合理限制,并禁止将其作为一种替代性心理疾病辅助治疗工具。

免责声明:

1.资讯内容不构成投资建议,投资者应独立决策并自行承担风险

2.本文版权归属原作所有,仅代表作者本人观点,不代表Bi123的观点或立场