与 AI 社区联合,黄仁勋背后藏着怎样的「野心」

托管

PoW

数据

一向不吝啬自己在「硬」实力上秀肌肉的英伟达,为降低生成式 AI 门槛,在软硬件方面推出了一系列重磅更新。

原文标题:《除了「翻车」,黄仁勋还牵手了》

撰文:张洁

来源:51CTO 技术栈

「买得越多,省得越多!」黄仁勋深夜放言,毫不掩饰在这个大模型井喷时代的豪气。

在今年的世界顶级计算机图形学会议 SIGGRAPH 上,老黄再度登上舞台。不过除了发布让老黄本人差点翻车的、号称比 A100 更牛逼的旗舰级的 RTX 6000 以外,更为让人寻味的,是老黄突然宣布的生态玩法:英伟达要跟 Hugging Face 手拉手了!

一向不吝啬自己在「硬」实力上秀肌肉的英伟达,为降低生成式 AI 门槛,在软硬件方面推出了一系列重磅更新。这都可以理解。但 AI 开发工具、开发平台、大模型齐备的英伟达,选择与全球范围内最大的 AI 社区强强联合,一定有藏着老黄更大的「野心」。

借东风:英伟达因何选择 Hugging Face

在硬件方面,GH200 超级芯片的更新版的推出引起了普遍关注。相比 x86 架构的 CPU,GPU 在能效上的优势更明显。黄仁勋打了个比方,同样使用 1 亿美元打造数据中心,可以买下 8800 个 x86 的 CPU 或 2500 套 GH200,但后者的 AI 算力是前者的 12 倍,同时能耗减少 20 倍。

不过,要让大模型的使用门槛进一步降低,硬基座的夯实只是一方面,软环境的升级同样不可或缺。在推出 NVIDIA DGX Cloud 短短几个月后,英伟达昨天又官宣了与 Hugging Face 的合作。事实上,在外界看来,这一合作并不令人意外。那么,为何是 Hugging Face?

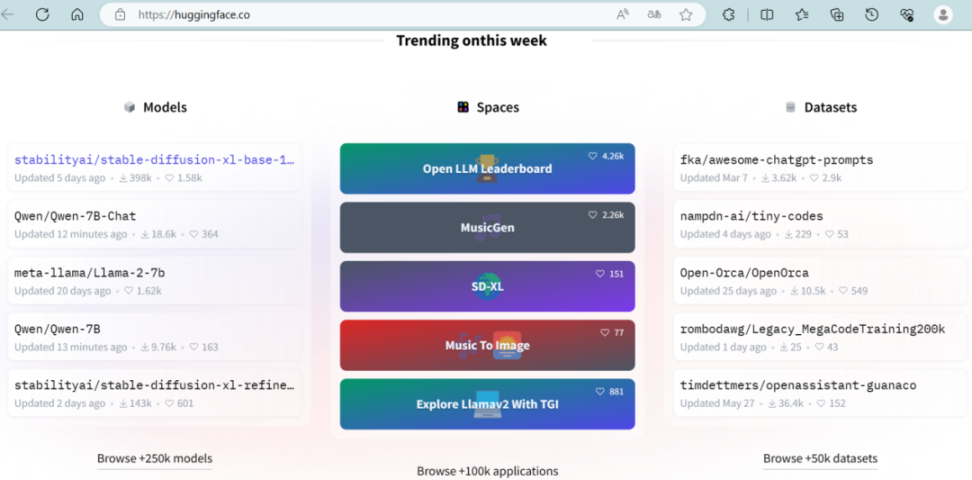

依靠明星项目 Transformers 库走红的 Hugging Face 是一个针对机器学习的开源平台和社区,在当下被视为大模型托管领域的 Github。其官网显示,Hugging Face 目前拥有 25 万 + 的模型,5 万 + 数据集。

图源:https://huggingface.co/

通过 Hugging Face,企业可以直接通过 API 接入大模型能力,也可以上传自己的数据,在众多开源项目中找到适合自身的模型和训练方法,直接训练一个属于企业自己的大模型。可以说,Hugging Face 集成开放模型的优势有目共睹。

双方的合作将英伟达之前发布的 DGX Cloud 和 Hugging Face 平台集成到了一起,通过让开发人员在 Hugging Face 平台中访问 NVIDIA DGX Cloud AI 超级计算来训练和调整高级 AI 模型。

「Hugging Face 和英伟达正在将世界上最大的 AI 社区与 NVIDIA 在世界领先云中的 AI 计算平台连接起来。总之,英伟达 AI 计算对于 Hugging Face 社区来说只需点击一下即可。」黄仁勋如此说道。

两者的集成使 Hugging Face 用户能轻松实现对 NVIDIA 多节点 AI 超级计算平台的一键式访问。作为合作的一部分,Hugging Face 将提供一项名为 Training Cluster as a Service 的新服务,以简化为企业创建新的和自定义的生成 AI 模型的过程。该服务由 NVIDIA DGX Cloud 提供支持,将在未来几个月内推出。

大模型乱战:「大炮打蚊子」的无奈

在英伟达之前,包括 AMD、亚马逊在内的诸多巨头已经和 Hugging Face 达成了紧密合作。由此可见,这一现象并非偶然,至少折射出了大模型赛道中一种新的趋向的形成——除了成为大模型的供应商,也可以选择成为大模型的服务平台。

不可否认,自从 ChatGPT 发布后,大模型的发展前所未有、日新月异。通过模型的巨量化可以提高人工智能的通用属性,并降低人工智能的应用门槛。但是大模型的应用落地一直存在诸多挑战,如何让更多行业和场景真正用起来也是业界频频讨论的关键议题。归结起来,其矛盾主要集中于以下几个方面:

首先,不是所有场景都需要大模型。虽然普遍认为大模型在诸多行业能发挥巨大价值,但也有一些数据量小、任务并不复杂的场景,并不适合使用大模型,否则就是「大炮打蚊子」。

其次,大模型不是参数数量越大越好,泛化能力才是其主要价值。正如中国科学院自动化研究所研究员王金桥曾提到的,「在生活中,百分之八九十场景的问题都属于小样本问题。」现实中如何快速适配不同场景才是大模型应用的难点所在。

再者,大模型不是万能的,不要寄希望于一个大模型解决所有问题。人工智能著名学者吴恩达曾表示,「在消费互联网行业中,我们只需训练少数机器学习模型就能服务 10 亿用户。然而在制造业中,有 1 万家制造商就要搭建 1 万个定制模型。」大模型要真正落地还需要解决通用性和个性化之间的问题。

整体来说,大模型上线只是第一步,如何应用到具体的行业场景中,抢占到用户和市场才是这场战役的奥义所在。随着五花八门的大模型陆续上线,关于大模型落地的矛盾愈发凸显。

因此,纵观国内外大模型领域的发展动向,可以发现,看似花团锦簇的繁荣表象之下,巨头们的大模型之争已经逐渐从大模型本身扩展到了大模型之外的角落。想依靠单一自建大模型打天下的理想在当下反而不太现实。

当然,大模型赛道还是卷得很厉害,颇有你方唱罢我登场之势。但是巨头自建大模型的目的,防守之意远大于进攻。绝大多数入场玩家不再执着于训练出一个超越 ChatGPT 形态的产品,他们建立自有大模型更多地是为现有业务加上护盾。「你有我也有」才是大家共在一张谈判桌的前提,「你有我没有」显然表示你连上桌资格都没有。

调转船头:MaaS 成为新航向

这种意识在国内的大模型市场也逐渐显露端倪。

纵观国内企业构建大模型的历程,大家几乎都是在同一起跑线起步。没有一骑绝尘的领先者,百花齐放的形态下,群雄逐鹿、你追我赶成为常态。

百度文心大模型已经迭代到了 3.5 版本;腾讯成立了由张正友带队研发的混元助手项目组;阿里发布「通义千问」后,还推出「通义听悟」且正式开启公测;华为的「盘古」大模型在推出后甚至还接入了鸿蒙的底座。

新技术发展过程中,当限制因素逐渐被解决后,其在产业的应用便会迅速落地。大模型逐渐过渡到商业化落地阶段已成为必然。但是在发现单纯依靠大模型还无法打通商业化之路时,调转船头成为了必然。

由于中国并没有 Hugging Face 这样的模型服务平台,各大云厂商成为了这场转向的主角。因为无论大模型如何迭代,技术栈如何演变,算力永远是大模型的刚需。作为计算的底层支撑,云厂商的参与是必然的。

在大模型这座金矿尚有诸多不确定性时,云服务商选择的「你们淘金,我卖水」的模式逐渐成为新的发展路径。在去年的云栖大会上,阿里云 CTO 周靖人首次提到了 MaaS 这个词。

MaaS,Model as a Service,即「模型即服务」,顾名思义,以模型为核心提供服务。此后在「百模大战」中,这一发展模式开始开花结果。虽然对外宣传的侧重各有不同,但形式基本一致,自研模型和第三方模型一起在云平台上提供服务。

在阿里云发起的 AI 模型社区魔搭中,集聚了 180 多万 AI 开发者和 900 多个 AI 模型;百度最早发布文心一言大模型,现在也已在百度上线第三方模型;腾讯甚至在发布模型平台之外,发布了作为中间层工具的向量数据库产品。而更为典型的是火山引擎。

今年 6 月 28 日,火山引擎发布了大模型服务平台「火山方舟」,面向企业提供模型精调、评测、推理等全方位的平台服务。此外,火山引擎还推出了「模型商店」,以此方便企业挑选合适的模型进行组合。

火山引擎智能算法负责人吴迪表示,火山方舟平台一方面会在资源和优化方面跟模型提供商进行非常深度的合作,长期致力于降低推理成本,另一方面,火山算法团队会和客户做重点的应用共建和应用落地,催化整个大模型、大算力在千行百业的落地速度。

结语:MaaS 选型需要考虑的关键因素

最后,站在企业用户的角度,MaaS 的诞生的确带来了诸多的便利。

它允许企业快速轻松地访问强大的 AI 模型,而无需从头开始开发和训练自己的大模型。这消除了对昂贵的软硬件的需求,以及自己开发和测试所需的时间和资源。与此同时,MaaS 还使企业更容易尝试不同的大模型和技术。通过访问预训练模型,企业可以快速轻松地试验不同的选择,从而快速确定哪些模型最能满足他们的需求。

但是在选择 MaaS 平台时,用户也需要考虑几个关键因素。

其一,应该考虑平台提供的模型和算法类型。不同的平台提供不同的模型和算法,因此应该确保你选择的平台提供你需要的模型和算法。

其二,应该考虑 MaaS 平台的定价结构。不同的平台提供不同的定价模型,因此应该确保你选择的平台提供满足你需求的定价模型。

其三,应该考虑 MaaS 平台提供的客户支持级别。不同的平台提供不同级别的客户支持,因此应该确保你选择的平台提供你需要的支持级别。

尽管使用 MaaS 具有许多优势,但企业在创建 AI 模型时仍面临一些常见挑战,比如如何选择正确的模型类型、如何使用正确的数据训练模型以及如何定期评估模型。

长远来说,无论是 MaaS 的构建者、合作者还是用户,依旧任重而道远。

参考链接:

https://nvidianews.nvidia.com/news/nvidia-and-hugging-face-to-connect-millions-of-developers-to-generative-ai-supercomputing

https://www.bianews.com/news/details?id=156713

https://medium.com/@pearcenjordan/what-is-maas-unlock-the-power-of-model-as-a-service-27ebbcaefce6

免责声明:

1.资讯内容不构成投资建议,投资者应独立决策并自行承担风险

2.本文版权归属原作所有,仅代表作者本人观点,不代表Bi123的观点或立场